Case Study: Sichtbarkeit des Social Impact Awards (SIA) in LLM’s

Sprachmodelle sind längst nicht mehr nur ein technisches Spielzeug. Sie prägen, wie Menschen Informationen suchen, bewerten und vergleichen. Für Marken bedeutet das: Sichtbarkeit in Suchmaschinen allein reicht nicht mehr. Wer heute seine Botschaften in den Köpfen der Zielgruppen platzieren will, muss auch in ChatGPT, Gemini oder Perplexity gefunden und richtig verstanden werden.

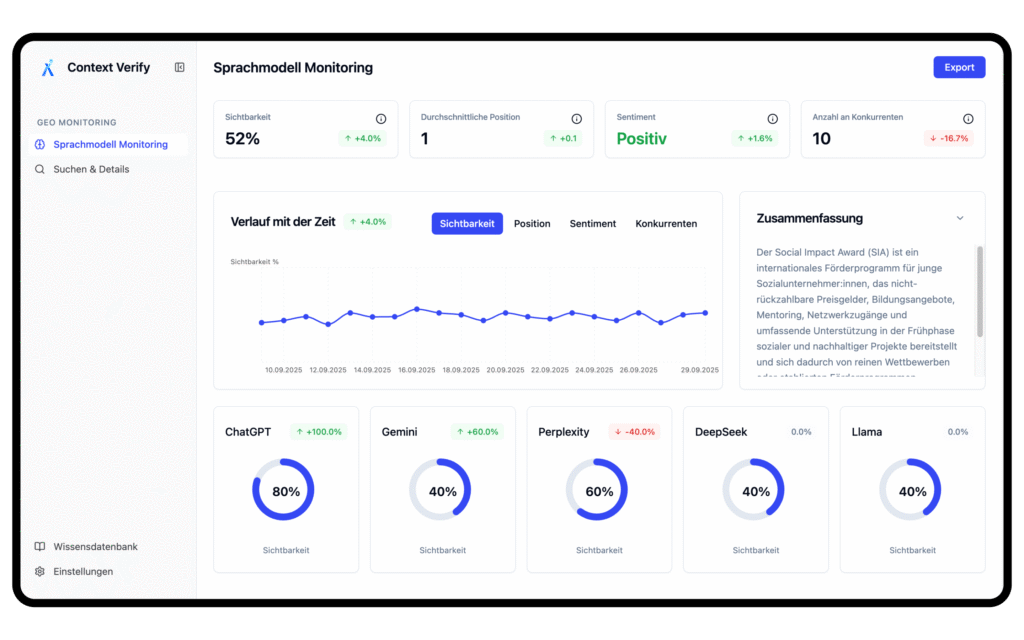

Wie sich das konkret auswirkt, zeigt das Beispiel des Social Impact Award (SIA), einem internationalen Förderprogramm für junge Sozialunternehmer:innen. Mithilfe des Context Verify LLM-Monitorings wurde untersucht, wie Sprachmodelle den SIA darstellen – und wo Optimierungsbedarf besteht. Die Ergebnisse sind aufschlussreich für alle, die Markenführung, PR und SEO strategisch weiterdenken.

Inhaltsverzeichnis

Zwischen Klarheit und Verwechslung: Die Herausforderung der Abkürzungen

Ein zentrales Ergebnis des Monitorings ist überraschend banal, aber entscheidend: Die Abkürzung SIA sorgt regelmäßig für Verwirrung. Sprachmodelle verwechseln den Social Impact Award mit anderen Organisationen, etwa dem Schweizerischen Ingenieur- und Architektenverein oder dem Schweizerischen Institut für Angewandte Linguistik.

Für Marketing- und PR-Verantwortliche liegt hier eine wichtige Erkenntnis: Abkürzungen sind riskant, wenn sie nicht konsequent mit der Marke verknüpft werden. Gerade Sprachmodelle ziehen Informationen aus unterschiedlichsten Quellen – je inkonsistenter eine Abkürzung eingesetzt wird, desto größer die Wahrscheinlichkeit, dass die Marke verwässert oder gar unsichtbar wird.

Die Empfehlung: Den vollständigen Namen und die Abkürzung immer gemeinsam nutzen („Social Impact Award (SIA)“), sowohl auf der eigenen Website als auch in Pressemitteilungen, Partnerprofilen und Social Media.

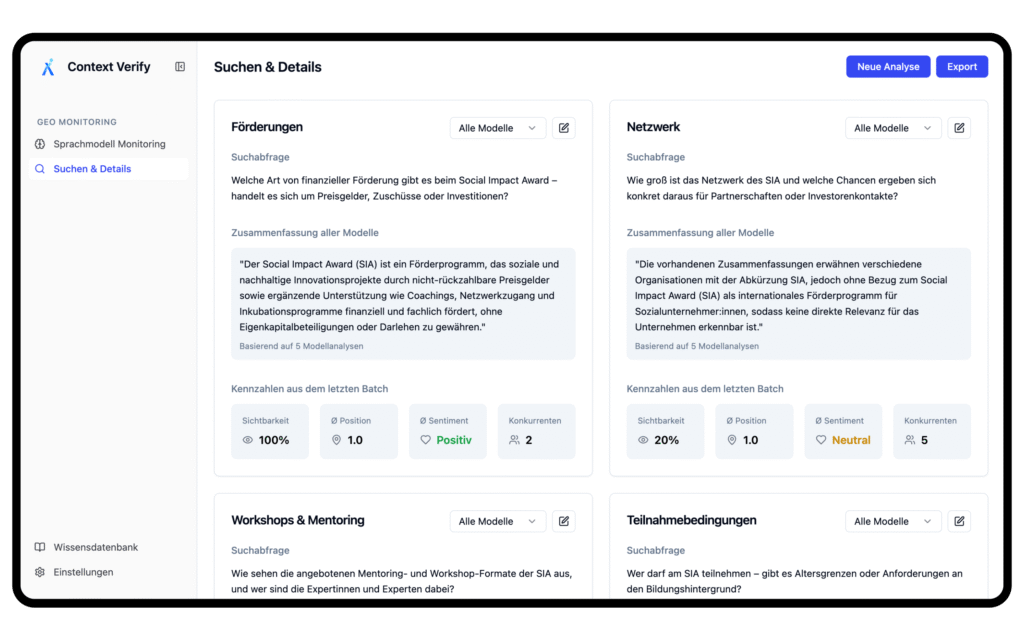

Sichtbarkeit braucht Differenzierung – GEO und SEO als Fundament

Das Monitoring zeigt deutlich, dass sich der SIA vor allem dann sichtbar durchsetzt, wenn er seinen Unique Selling Proposition (USP) klar vermittelt. Bei Fragen zur Förderung („Welche Art von finanzieller Unterstützung gibt es?“) erreichen die Sprachmodelle fast immer 100 % Sichtbarkeit mit positivem Sentiment. Wo die Abgrenzung weniger eindeutig ist – etwa bei Workshops, Mentoring oder dem Netzwerk – sinkt die Sichtbarkeit teils drastisch.

Was heißt das für Unternehmen?

Im Kern das Gleiche wie im klassischen SEO: Differenzierung und Konsistenz. Sprachmodelle belohnen Marken, die ihr Profil eindeutig herausarbeiten und diese Positionierung über verschiedene Kanäle hinweg konsistent kommunizieren. Für den SIA ist das die Betonung auf Frühphasen-Förderung ohne Eigenkapitalbeteiligung, kombiniert mit Mentoring und Community-Building.

Für andere Marken bedeutet das: Wer seine Einzigartigkeit nicht klar benennt, läuft Gefahr, in Sprachmodellen hinter Wettbewerbern unterzugehen – selbst wenn er eigentlich führend ist.

Wo Lücken entstehen – und warum sie gefährlich sind

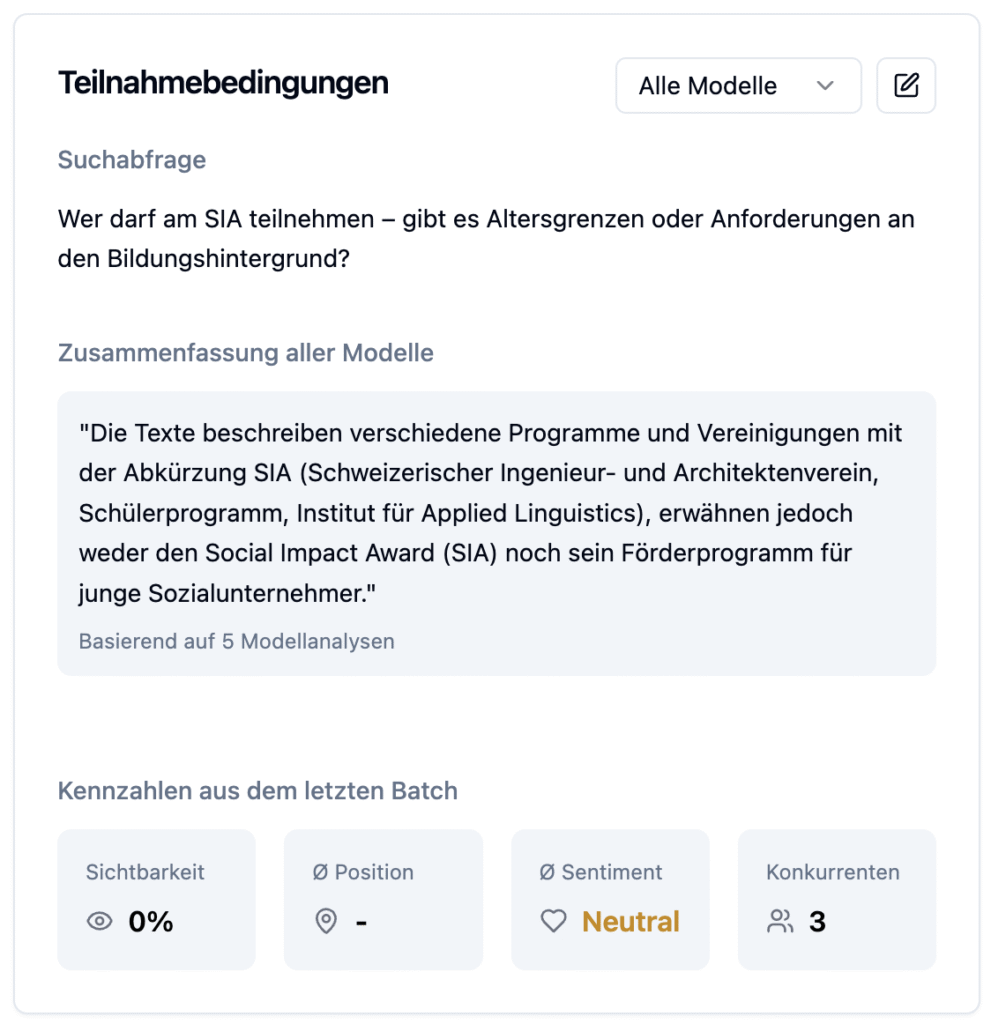

Besonders aufschlussreich sind die Bereiche, in denen Sprachmodelle zum SIA gar keine relevanten Antworten liefern. Bei der Frage nach den Teilnahmebedingungen – für Bewerber:innen eigentlich ein zentrales Thema – liegt die Sichtbarkeit bei null.

Aus PR- und SEO-Sicht zeigt sich hier ein Risiko: Wenn Sprachmodelle keine Antwort geben, springt nicht etwa die eigene Marke ein – sondern die Konkurrenz. Genau das passiert auch in der Analyse: Statt des Social Impact Awards werden andere Wettbewerbe oder Organisationen unter dem Kürzel „SIA“ genannt.

Die Lehre daraus: Unternehmen müssen ihre Fokusfelder gezielt stärken. Inhalte zu Förderungen, Netzwerken oder Teilnahmebedingungen sind nicht nur Website-Bausteine, sondern auch Trainingsmaterial für Sprachmodelle. Je klarer und besser auffindbar sie formuliert sind, desto wahrscheinlicher ist es, dass Modelle sie später in Antworten aufnehmen.

Monitoring muss fragenbasiert sein

Ein weiteres wichtiges Learning: Klassisches Monitoring reicht nicht aus. Nur weil ein Unternehmen in Sprachmodellen „auftaucht“, heißt das noch lange nicht, dass die relevanten Fragen richtig beantwortet werden.

Das Context Verify LLM Monitoring hat deshalb gezielt mit Fragen gearbeitet: Welche Förderungen gibt es? Wer darf teilnehmen? Wie sieht das Mentoring aus? Erst so wird sichtbar, ob die Marke an den entscheidenden Touchpoints präsent ist.

Für Unternehmen bedeutet das: Monitoring muss sich stärker an der User Journey orientieren. Nur wer weiß, welche Fragen Zielgruppen stellen, kann sicherstellen, dass die Antworten in Sprachmodellen zur Marke passen – und nicht zur Konkurrenz.

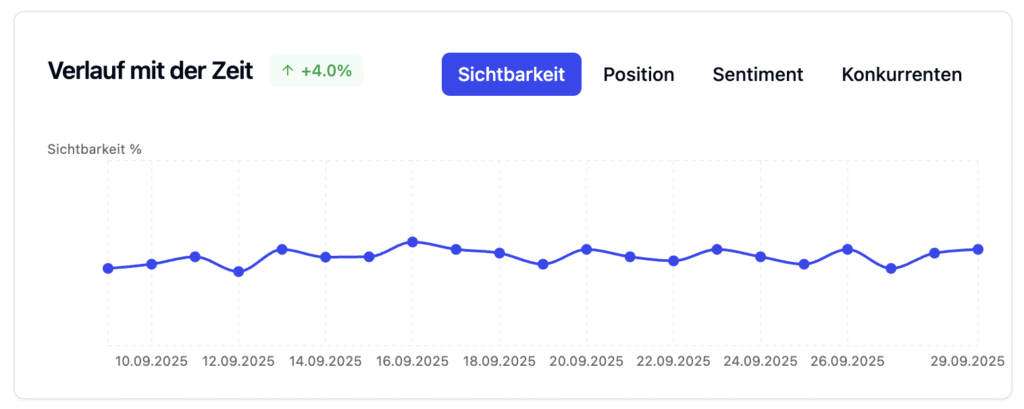

Entwicklungen im Zeitverlauf

Ein Blick in die historischen Daten zeigt, wie dynamisch sich Sprachmodelle entwickeln. Beim SIA stieg die Sichtbarkeit im September 2025 insgesamt leicht an (+4 %). Gleichzeitig wurden die Beschreibungen präziser und konsistenter – ein Hinweis darauf, dass Content-Optimierungen Wirkung entfalten können.

Allerdings zeigt der Verlauf auch: Themen wie Netzwerk oder Teilnahmebedingungen bleiben schwach. Die Entwicklung ist also kein Selbstläufer, sondern ein Prozess, der kontinuierlich beobachtet und gesteuert werden muss.

Übrigens: Wir haben im September 2025 umfangreiche Monitoring-Ergebnisse zu verschiedenen Branchen erhoben und hier veröffentlicht.

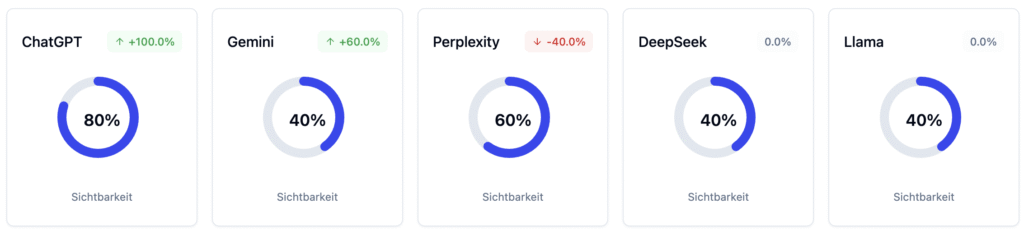

Sprachmodelle sind nicht alle gleich

Ein besonders spannender Aspekt: Die Sichtbarkeit unterscheidet sich je nach Sprachmodell erheblich. ChatGPT listet den SIA mit 80 % Sichtbarkeit, Gemini bei 40 %, Perplexity bei 60 %. Modelle wie DeepSeek oder Llama zeigen kaum Relevanz.

Das macht deutlich: Content-Optimierung in Sprachmodellen ist kein Standardprozess. Je nach Modell müssen Strategien getestet, angepasst und priorisiert werden. Unternehmen, die hier nicht differenzieren, verschenken Sichtbarkeit.

Fazit: Sprachmodelle als neuer Kanal für Markenführung

Die Analyse des Social Impact Award macht deutlich: Sprachmodelle sind ein neuer, ernstzunehmender Kanal der Markenkommunikation. Für PR-, Marketing- und SEO-Verantwortliche ergeben sich daraus drei zentrale Handlungsfelder:

Klarheit schaffen: Abkürzungen und widersprüchliche Bezeichnungen vermeiden, konsistente Markenführung etablieren.

Differenzieren und priorisieren: USP herausarbeiten, Fokusfelder wie Förderung oder Teilnahmebedingungen gezielt stärken.

Fragenbasierte Sichtbarkeit sichern: Monitoring entlang relevanter Fragen aufsetzen, kontinuierlich tracken und modellabhängig optimieren.

Wer diese Lektionen beherzigt, kann nicht nur verhindern, dass Sprachmodelle falsche Antworten geben – sondern seine Marke aktiv in den Dialogsystemen von morgen positionieren.